ホーム

>> ヘッドライン

>>

PC修理のわたなべ

ホーム

>> ヘッドライン

>>

PC修理のわたなべ

| メイン | 簡易ヘッドライン |

|

|

現在データベースには 506 件のデータが登録されています。

はじめに

Stable Diffusionに最新の画像生成SDXL 1.0が更新されたので試してみた。

参考サイト

最新の画像生成AI「SDXL 1.0」実写系イラストのクオリティがすごい!!

モデルのインストール

BASEモデルをダウンロード (「models\Stable-diffusion」にコピー)

- sd_xl_base_1.0.safetensors

Refinerモデルをダウンロード (「models\Stable-diffusion」にコピー)

- sd_xl_refiner_1.0.safetensors

Refinerモデルをダウンロード (「models\VAE」にコピー)

- sdxl_vae.safetensors

画像生成

・Stable Diffusion checkpoint

- sd_xl_base_1.0.safetensors

・SD VAE

- sdxl_vae.safetensors

・プロンプト

(日本訳:横浜港に邪悪なモンスターが襲来してビームを吐いている。地球防衛軍の戦闘機が応戦している)

Evil monsters are attacking Yokohama Port and emitting beams. Earth Defense Force fighters are fighting back

・Width

- 1024

・Height

- 1024

「Send to img2img」ボタンをクリックして画像を「img2img」に送る。

モデルを「stable-diffusion-xl-refiner-1.0」に変更、VAEはそのままでいい。

考察

画像の分解能が大変よくなったような気がする。

手などの不具合も減少されたようである。

リアル系やLORAなども使用できるようになれば、よりいいかなと思う。

ポッドキャスト :

video/mp4

ポッドキャスト :

video/mp4

はじめに

以下の動画を拝見した。

【StableDiffusion】ワンクリックで動画化!?AI画像から動画を作成する方法

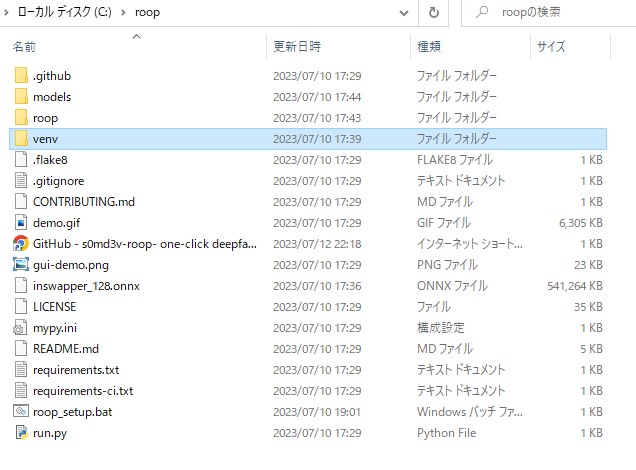

roop構築

以下のサイトをご覧ください

Installation

Cドライブ以下で、コマンドプロンプトを起動

git clone https://github.com/s0md3v/roop

pip install -r requirements.txt

Acceleration

すべてのファイルを入れると以下のようになります。

※ファイル名:roop_setup.bat は、後ほど自作します

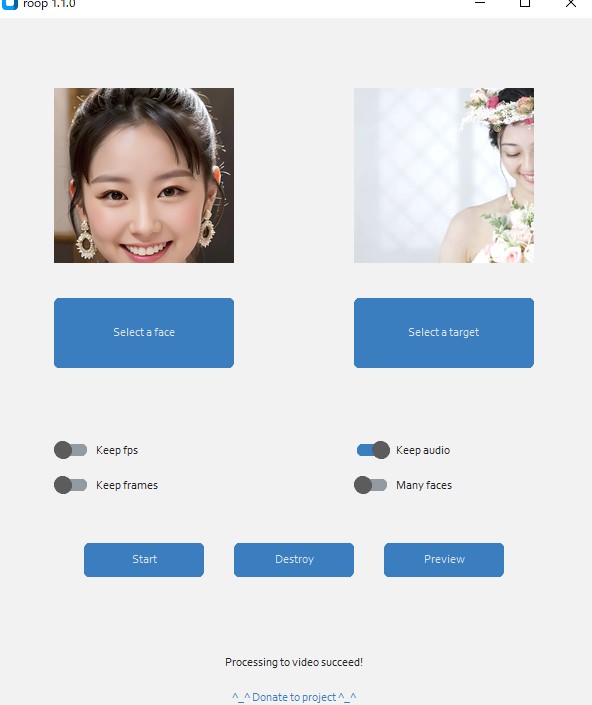

実践

Select face: 対象となる画像

Select target: 対象とする動画

「Start」ボタンで生成を開始します。

結果

考察

構築さえできれば、簡単に顔のスワップができるようになった。

venvを実行することが面倒だったので、バッチファイルを作成しました。

※ファイル名:roop_setup.bat

call venv\scripts\activate.bat

python run.py

「roop_setup.bat」を【roop】フォルダ下に置きました。

これで、バッチファイルを起動するだけで、「roop」アプリを起動できるようになりました。

はじめに

超簡単!顔の入れ替えをstable diffusionで可能とyoutubeで発見

- sd-webui-faceswap

参考サイト

sd-webui-faceswap のインストール

【extensions】タブ→【Install From URL】→【URL for extension’s git repository】に以下のサイトからインストール

https://github.com/IntellectzProductions/sd-webui-faceswap.git

「inswapper_128.onnx」モデルのインストール

inswapper_128.onnx ? deepinsight/inswapper at main (huggingface.co)

https://huggingface.co/deepinsight/inswapper/blob/main/inswapper_128.onnx

「\(stable diffusionフォルダ)\extensions\sd-webui-faceswap\models」へ、「inswapper_128.onnx」モデルをインストール

Visual C++のダウンロード

Visual Studio Tools のダウンロード – Windows、Mac、Linux 用の無料インストール (microsoft.com)

再起動します

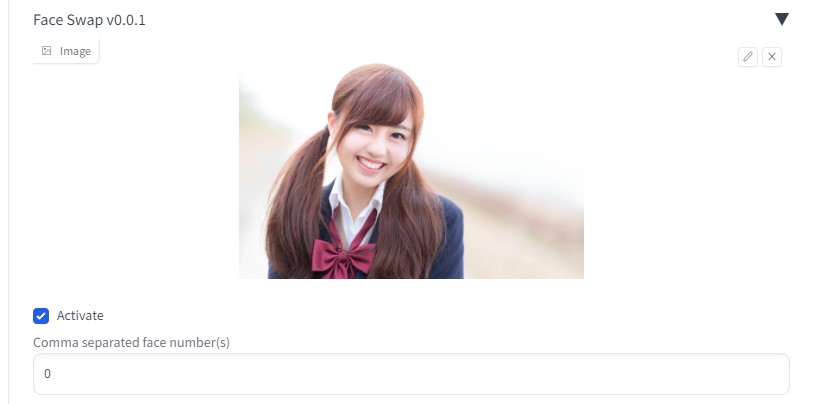

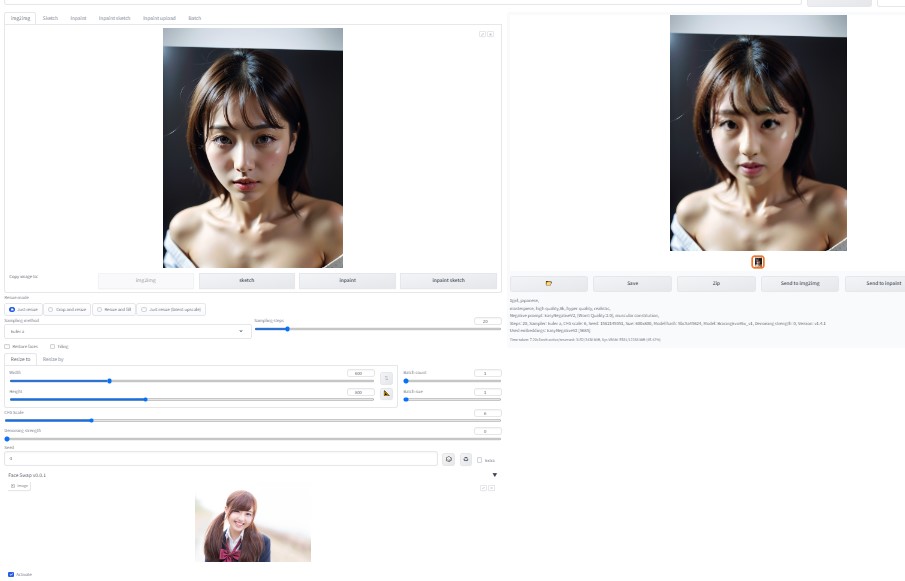

実践

- 「Face_Swap」から「Activate」をチェック

- お好きな画像を挿入

素材:https://www.pakutaso.com/

●img2imgにて、実践

考察

超簡単に、顔のスワップができるようになった。

簡単ではあるが、変換後の顔画像の分解能が少し低いように感じる。

解像度を上げる方法があるかもしれません。

お遊びでスワップ画像を確認したい方におすすめします。

今回一番参考になったサイトは、以下の通りです。

GitHub – IntellectzProductions/sd-webui-faceswap: FaceSwap Extension – Automatic 1111

ポッドキャスト :

video/mp4

ポッドキャスト :

video/mp4

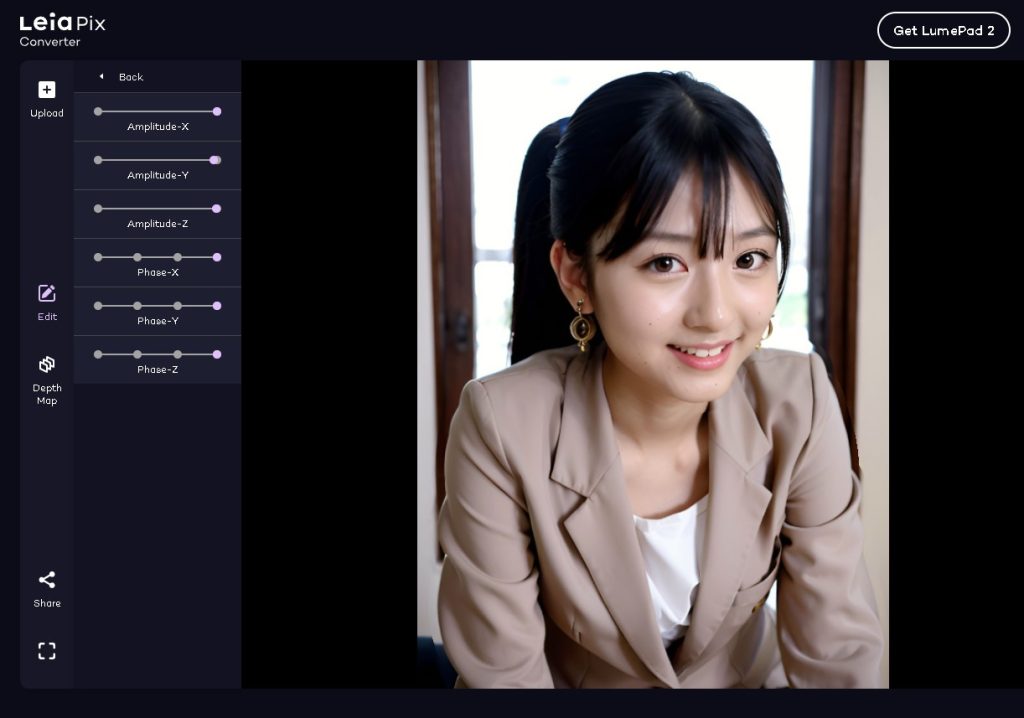

はじめに

またひとつ、静止画からAI動画を生成できるアプリをみつけた

- LeiaPix Converter

【公式サイト】 LeiaPix Converter | Depth Animations

参考サイト

- 超かんたん。静止画をAIで動画できる!LeiaPix Converterの使い方! (blogcake.net)

- 静止画像をビデオアニメーションに変換するAIツール『Leiapix Converter』 (ai-today.net)

生成過程

【AI画像生成】

【公式サイト】 LeiaPix Converter | Depth Animations

※AI生成画像をアップロード後

完成動画

考察

1枚の画像から、ゆらぎのある動画を簡単に生成できた。

贅沢を言えば、音声を追加できるようになれば、いいかも。

ポッドキャスト :

video/mp4

ポッドキャスト :

video/mp4

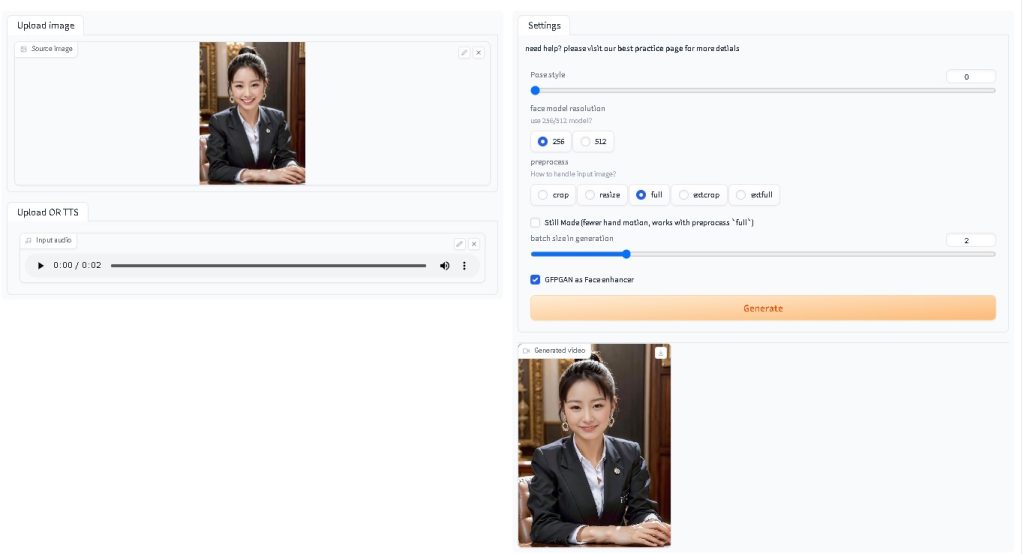

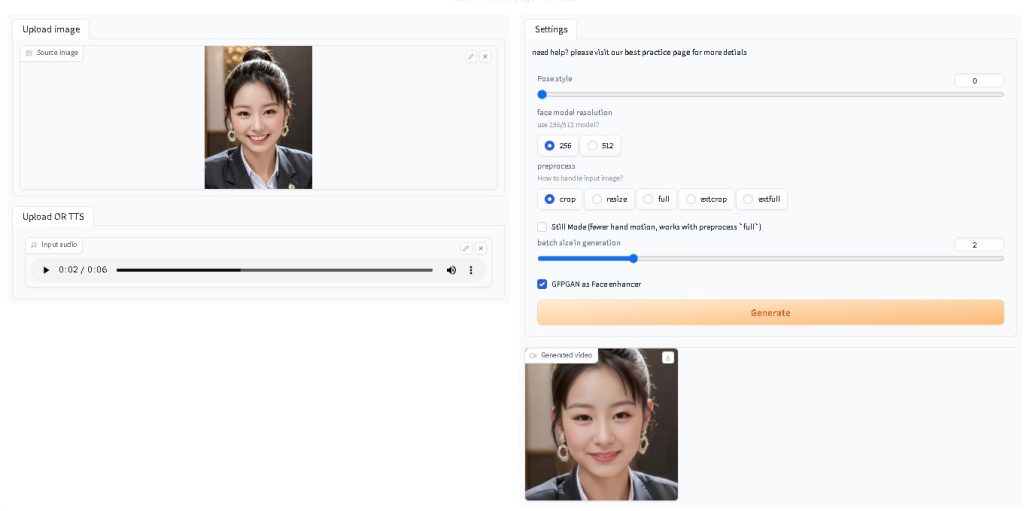

はじめに

音声に合わせて、画像の動画をつくりたいと思った。

【ツール】

- SadTalker

参考サイト

SadTalkerのインストールは、以下をご覧ください。

口パク(リップシンク)AI「SadTalker」をWebUI(1111)拡張機能として導入する方法 | 経済的生活日誌 (economylife.net)

SadTalkerの使い方と魅力、画像と音声からアニメーションを作ろう! | 定年後のスローライフブログ (yanai-ke.com)

SadTalkerの設定資料

拡張機能URL

https://github.com/Winfredy/SadTalker

モデルの配置

stable-diffusion-webui/models/SadTalker

以下のサイトから、すべてのファイルをダウンロードし、上記フォルダ以下にコピーする。

sadtalker_checkpoints – Google ドライブ

SadTalkerをつかってみた

txt2imgにて、画像を作成

【その1】

【その2】

SadTalkerに画像と音声を合成

※音声は、音読さん ( https://ondoku3.com/ja/ )

【その1】

【その2】

ビデオエディター(windows標準アプリ)にて、動画を結合

※はじめて使いましたが、使いやすかったです。

完成動画

リンのあいさつ

考察

1枚の画像から、音声動画ができるようになった。

Stable Diffusion の各動画ツールと違い、動画内の画質・人物・風景が相違なく動くのが、すごくよかった。

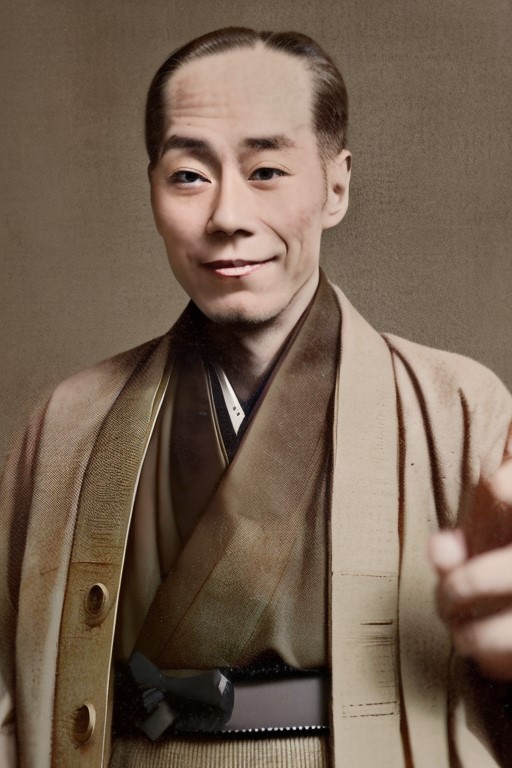

はじめに

1枚画像でLoRAを作成してみる。

【モデル】

- 福沢諭吉

写真の調整

写真の加工を簡単に施した。※手動修正

- 顔の修正

- 服の修正

白黒から高画質カラー写真へ

- 白黒画像・動画のカラー化(DeOldify)

- AI高画質化ツール(Real-ESRGAN)

【参考ページ】

AI高画質化ツール(Real-ESRGAN)実施後

白黒画像・動画のカラー化(DeOldify)実施後

LoRAを作成してみる

人物のみを切り抜く

【参考ページ】

イラスト切り抜き 作成 (Transparent-Background)

LoRA生成

LoRA完成

LoRAで遊んでみた

LoRAを使用して、画像を生成してみた

【作成例】

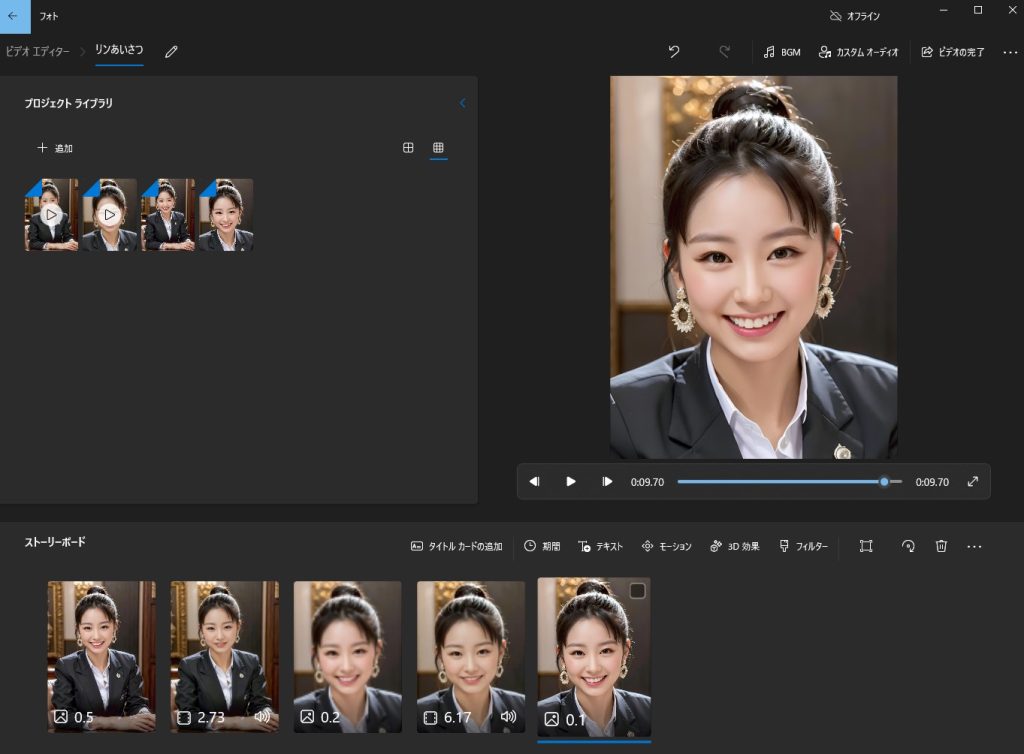

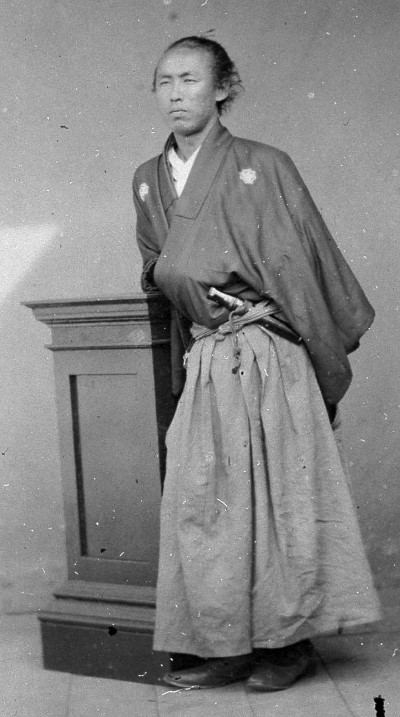

はじめに

1枚画像でLoRAを作成してみる。

【モデル】

- 坂本龍馬

写真の調整

写真の加工を簡単に施した。※手動修正

- 顔の修正

- 服の修正

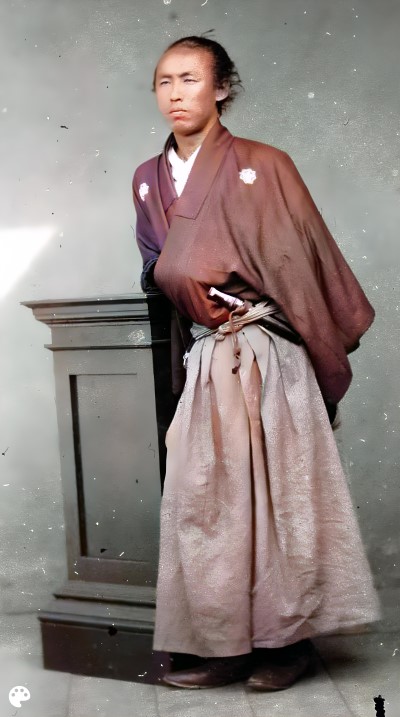

白黒から高画質カラー写真へ

- 白黒画像・動画のカラー化(DeOldify)

- AI高画質化ツール(Real-ESRGAN)

【参考ページ】

AI高画質化ツール(Real-ESRGAN)実施後

白黒画像・動画のカラー化(DeOldify)実施後

高画質なカラー写真が完成しました。

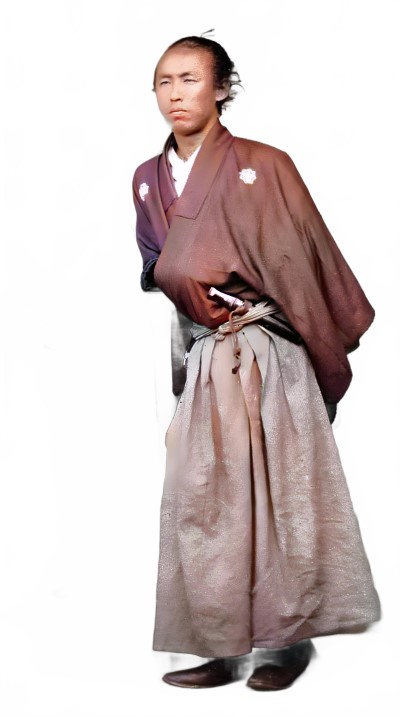

LoRAを作成してみる

人物のみを切り抜く

【参考ページ】

イラスト切り抜き 作成 (Transparent-Background)

学習用素材に加工

【参考サイト】

(3/20更新)Kohya版LoRA学習環境 簡単スタンドアローンセットアップ(※bmaltais氏の『Kohya’s GUI』の導入)

- 顔のみ・上半身・全身の3種類の素材を作成

【ryoma01.txt】

solo, simple_background, black_hair, 1boy, white_background, closed_mouth, closed_eyes, male_focus, portrait,

realistic

【ryoma02.txt】

solo, simple_background, black_hair, 1boy, white_background, weapon, male_focus, parted_lips, japanese_clothes, sword,

kimono, katana, sheath, sheathed, realistic, topknot

【ryoma03.txt】

solo, simple_background, black_hair, 1boy, white_background, closed_mouth, closed_eyes, male_focus, portrait, realisticsolo,

skirt, simple_background, black_hair, long_sleeves, 1boy, white_background, closed_mouth, standing, full_body, weapon, male_focus, japanese_clothes, sword,

facial_hair, katana, hakama, hakama_skirt, realistic, topknotsolo, simple_background, black_hair, 1boy, white_background, closed_mouth, closed_eyes, male_focus,

portrait, realistic

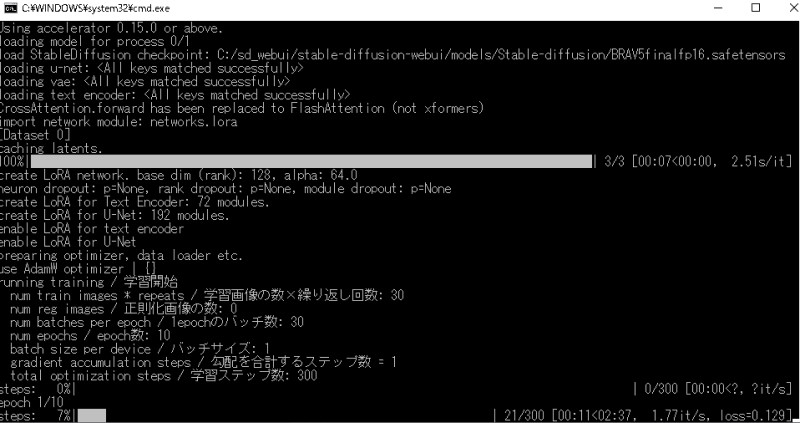

kohya_ss_webuiでLoRA作成

LoRA完成

LoRAで遊んでみた

LoRAを使用して、画像を生成してみた

【作成例】

考察

今回は、坂本龍馬でLoRA学習を実施し、AI画像を生成してみました。

1枚の画像から、立体感のある写真を生成することができました。

※ただし、実際に似ているかどうかわかりません

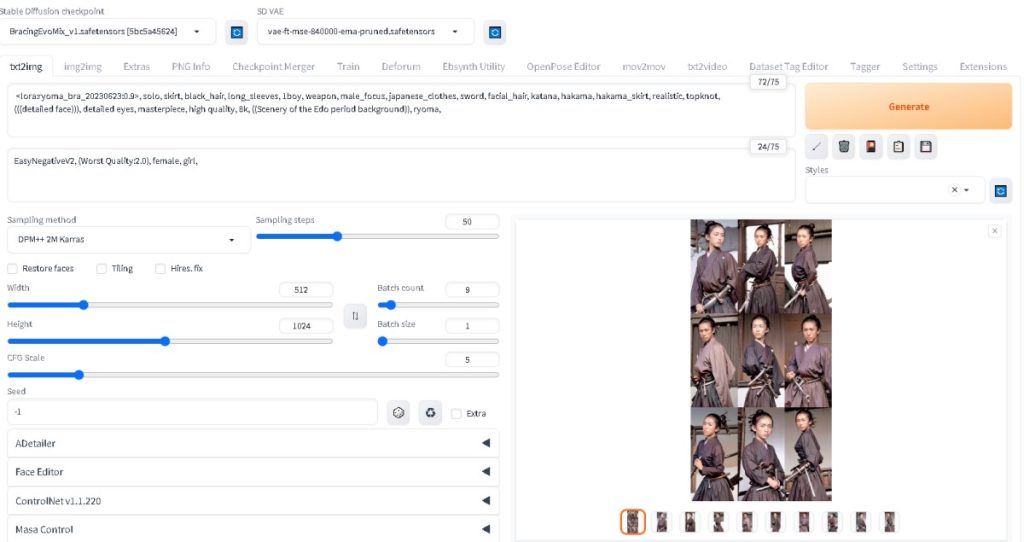

今回のSD WEBUIの設定画面を残しておきます。

【ryoma03.txt】のTaggerプロンプトを参考に入力しております。

もし参考になることがありましたら、ご自由にお使いください。

はじめに

Stable DiffusionでLora作成のために、素材をマスキングしたいと思った。

【今回の学習】

- Transparent-Background

参考サイト

切り抜きや背景透過・学習素材集めのお供に最適!Transparent-Backgroundが超高性能なので使ってみよう!ほか拡張機能の紹介【Stable Diffusion】

インストール方法

ダウンロードサイト

plemeri/transparent-background

インストール方法

コマンドプロンプトで以下の命令をする

※どこでも大丈夫です

pip install transparent-background

以上で終了です!※簡単ですね

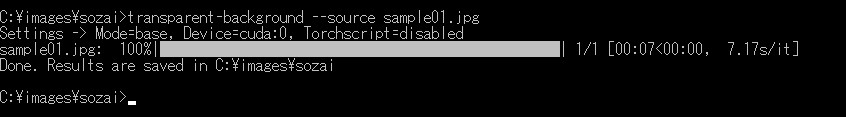

使用方法

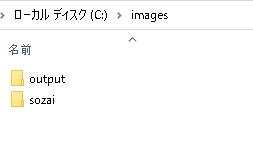

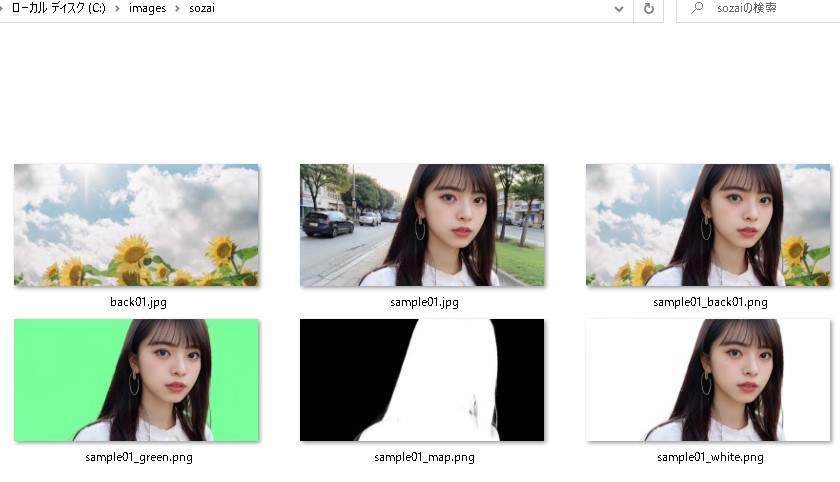

練習用として、Cドライプに「 images 」フォルダを作成します。

その下位ファルダに、「 sozai 」と「 output 」を作成します。

「 sozai 」フォルダに、「 sample01.jpg 」を追加しました。

「 sozai 」フォルダにて、コマンドプロンプトを起動させます。

以下の命令文で、切り抜き画像が作成されます。

transparent-background --source sample01.jpg

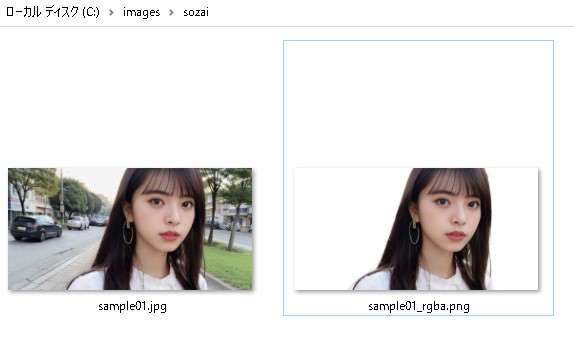

今回は、「 sozai 」フォルダに切り抜かれた画像「 sample01_rgba.png 」が生成されています。

比較

【元データ画像】

【切り抜かれた画像】

髪の毛などを確認すると、他のアプリと比較しても断然良い生成結果になりました。

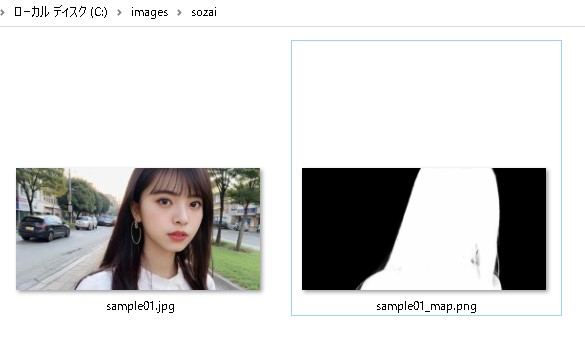

応用

マスクを作りたい場合

transparent-background --source sample01.jpg --type map

今回は、「 sozai 」フォルダにマスク画像「 sample01_map.png 」が生成されています。

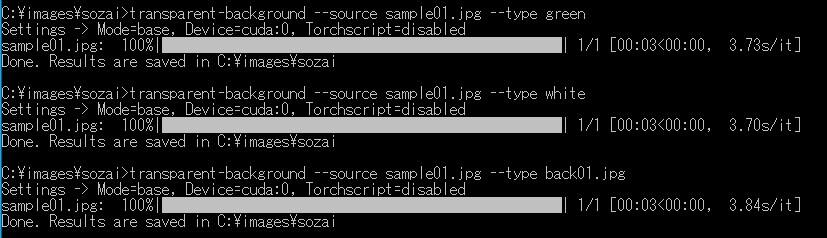

グリーン背景を作りたい場合

transparent-background --source sample01.jpg --type green

ホワイト背景を作りたい場合

transparent-background --source sample01.jpg --type white

目的の画像背景を作りたい場合

「 sozai 」フォルダに、「 back01.jpg 」を追加しました。

transparent-background --source sample01.jpg --type back01.jpg

【命令文】

【作成結果】

【背景画像を結合した結果】

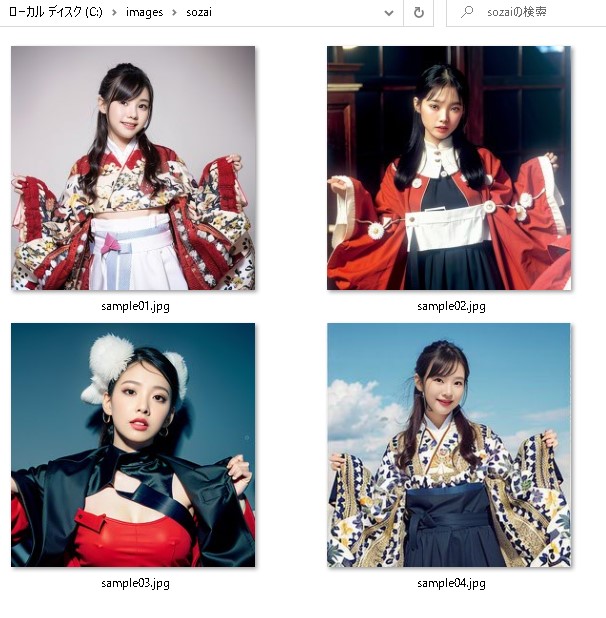

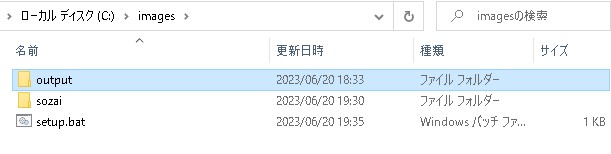

バッチファイル作成

フォルダ内のファイルを丸ごと変換するバッチファイルを作成します。

「 sozai 」フォルダに、「 sample01.jpg ?」を追加しました。

バッチファイルの作成「 setup.bat 」

※改行なしの一行で作成します。

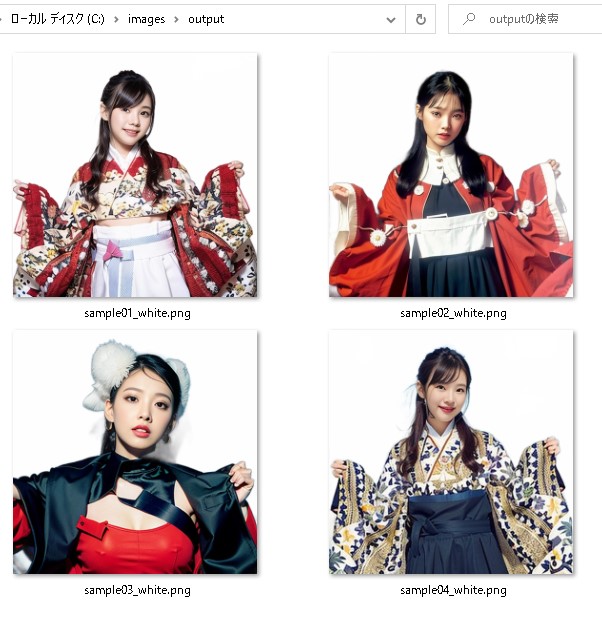

transparent-background --source "C:\images\sozai" --type white --dest "C:\images\output"

バッチファイル「 setup.bat 」をダブルクリックすると、「 output 」フォルダ内に、人物が切り抜かれた白い背景画像が生成されています。

結論

今まで手作業が多かった切り抜き画像がワンクリックで作成できるようになった。

Lora学習でも有益な活用が出来そうである。

ポッドキャスト :

video/mp4

ポッドキャスト :

video/mp4

はじめに

Stable Diffusionで動画作成できるコンテンツを探していたら、Deforumを発見。

早速、インストール・動画作成をしていきたいと思います。

参考サイト

Stable Diffusionの『Deforum』機能でアニメーション動画を作る方法 (その1)

Stable DiffusionでアニメーションAI動画を”簡単に”作る方法【deforum tutorial】(その2)

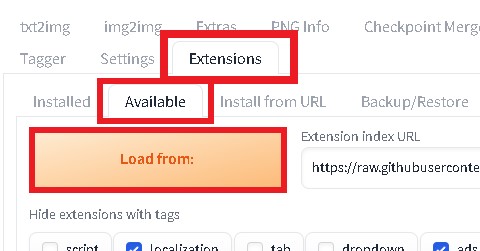

インストール方法

Stable Diffusionを起動する。

Extensions タブ → Available タブ → Load from: を選択

Deforumという項目があるので、右端のインストールをクリック

インストール完了後(1分程度)、リロードします。

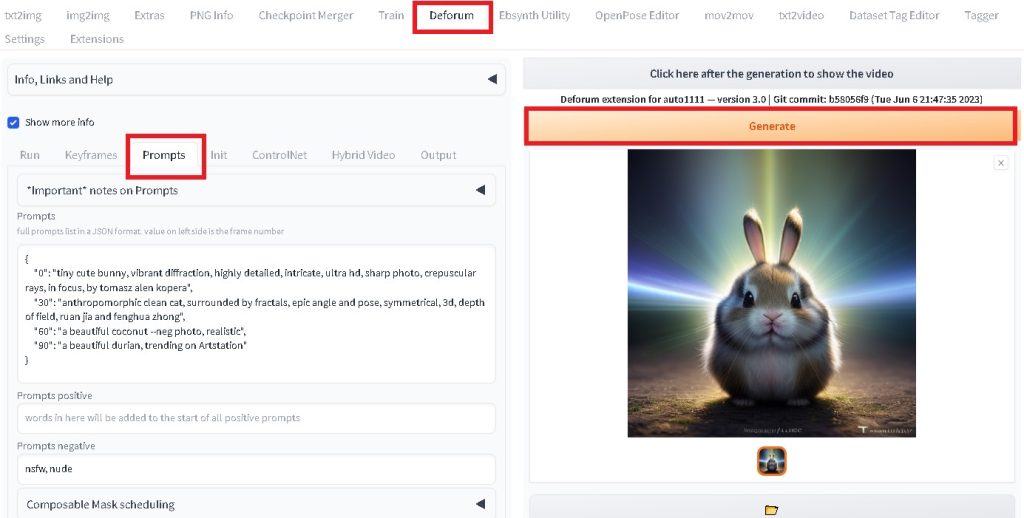

Deforumの操作方法

とりあえず、動画を作成してみます。

Deforum タブ → Prompts タブ → Genetate を選択

動画作成が終了したら、「 Click here ? 」をクリックすると動画を確認できます。

【完成動画】

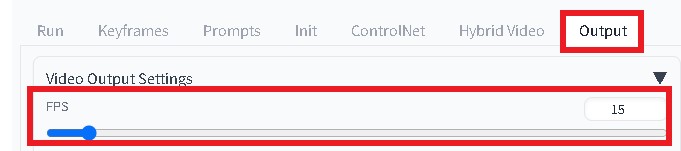

FPS(1秒間の使用枚数)

1秒間のキーフレームを変更します。

Output タブ → FPSの数値 を変更

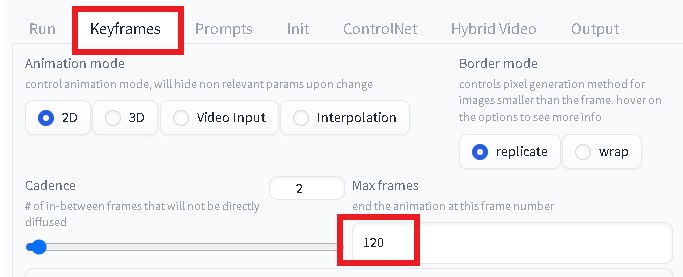

Max frames(動画の総枚数)

動画の総枚数を変更します。

Keyframes タブ → Max frames の数値 を変更

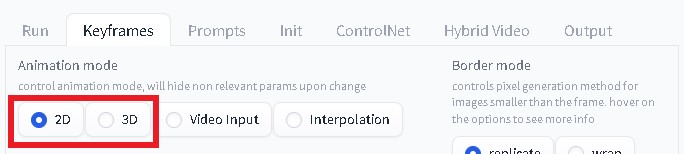

Animation mode (アニメ or 実写)

動画の総枚数を変更します。

Keyframes タブ → Animation mode を選択

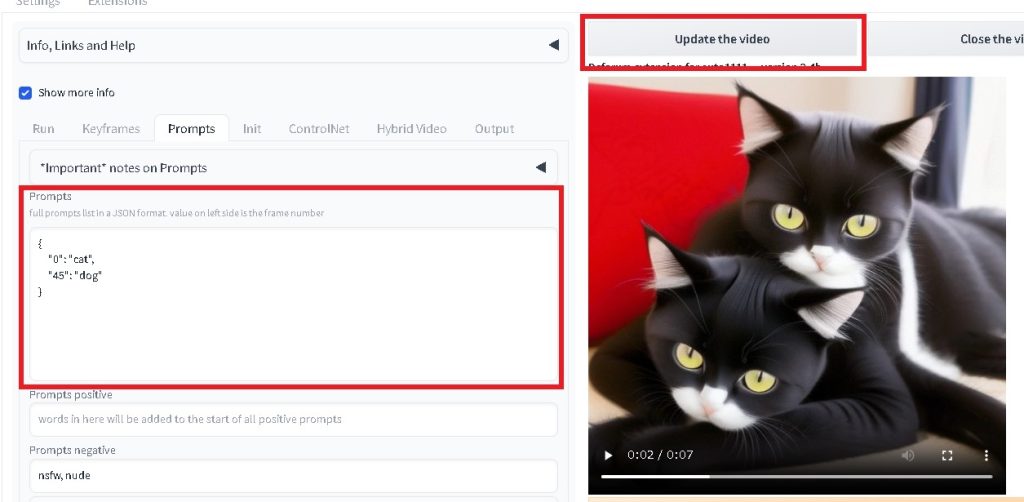

新規作成

Prompts にテキストを代入

"0": "cat",

"45": "dog"

Genetate を選択

動画生成後、 Update the video を選択すると動画を確認できます。

完成動画

考察

動画の1枚1枚が想像以上に相似していて、驚きました。

Prompts など、いろいろと変更して遊ぶことができそうです。

みなさんも楽しんでみてください!

おまけ動画

Prompts:

"0": "in forest,anime,1girl,16 years old",

"25": "in city,anime,1girl,18 years old",

"50": "in city,realistic,1girl,20 years old"

Max frames: 100

FPS: 10

ポッドキャスト :

video/mp4

ポッドキャスト :

video/mp4

はじめに

簡単なパラパラ動画を作成してみる

- Stable Diffusion

- FFmpeg

- EBsynth

参考サイト

サンプル動画

【sample.mp4】

以下のサイトから、サンプル動画を使用させていただきました。

作成方法

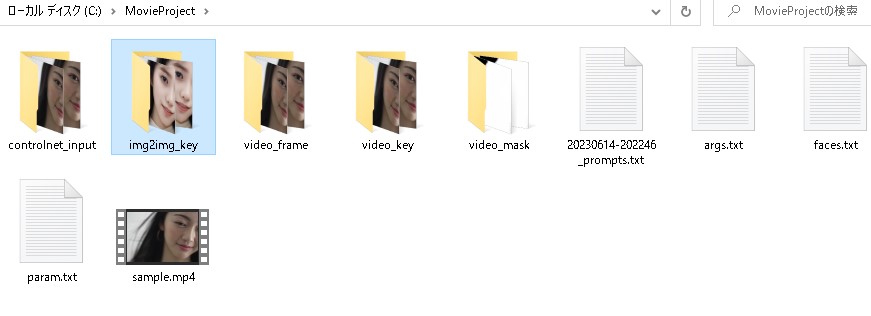

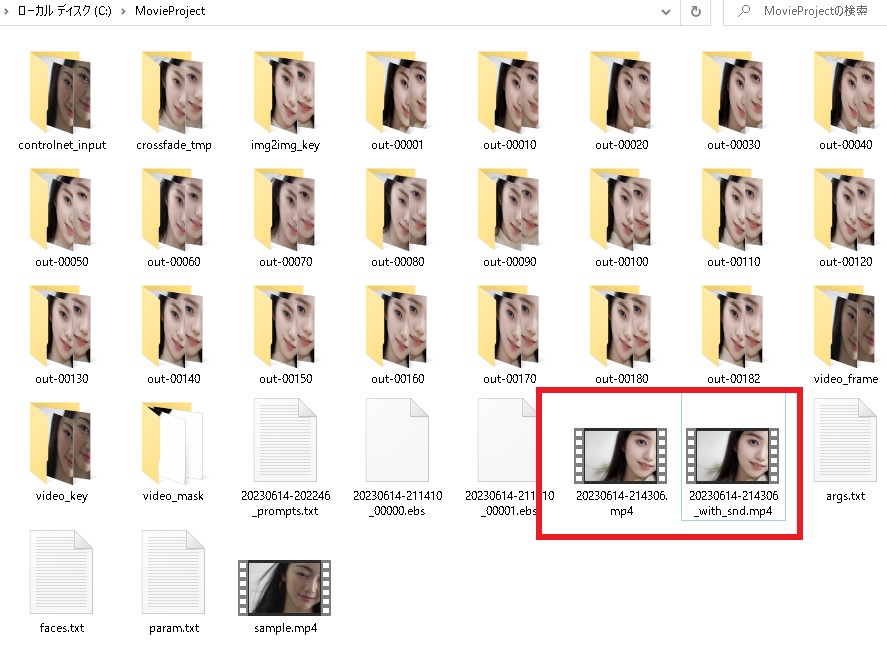

C:\MovieProject にサンプル動画を用意

videoフレームの抽出

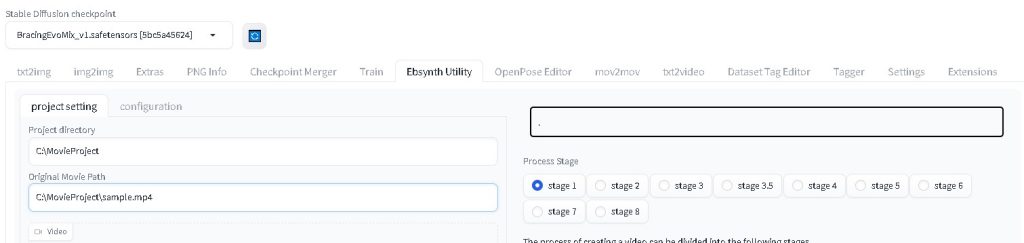

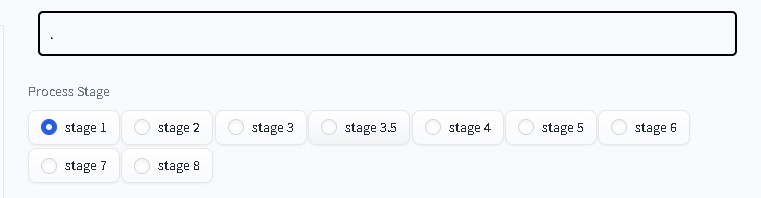

[ EbSynth Utility ]タブ → [ Project Setting ]タブ

project directory: C:\MovieProject

Original Movie Path: C:\MovieProject\sample.mp4

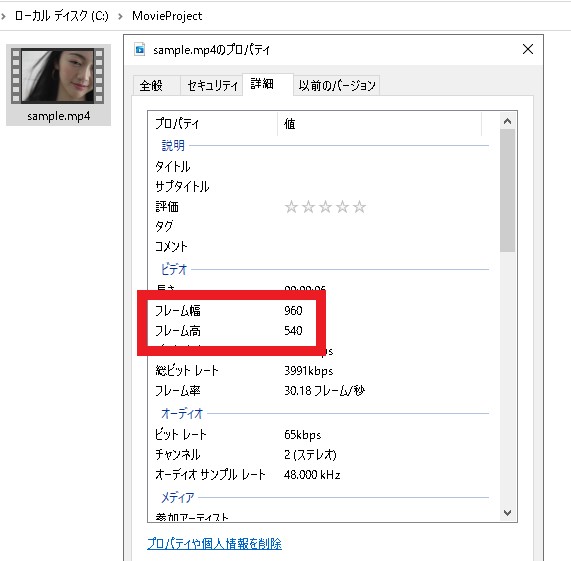

動画のフレーム幅とフレーム高を確認する。

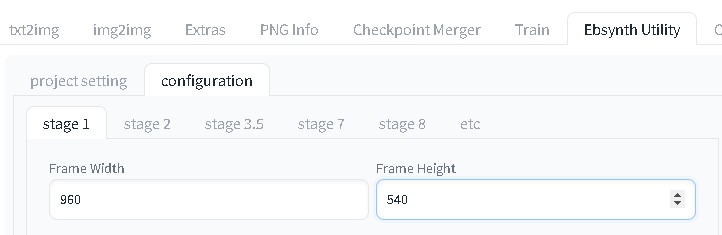

[ Cofiguration ]タブ → [ Stage1 ]タブ

Frame Width: 960

Frame Height: 540

「 Stage1 」をチェック!

「 Generate 」をクリック!

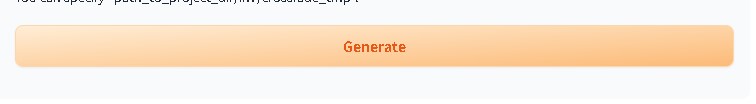

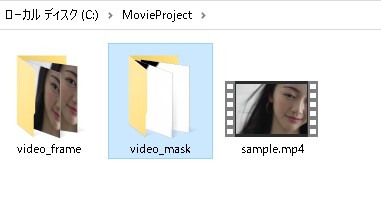

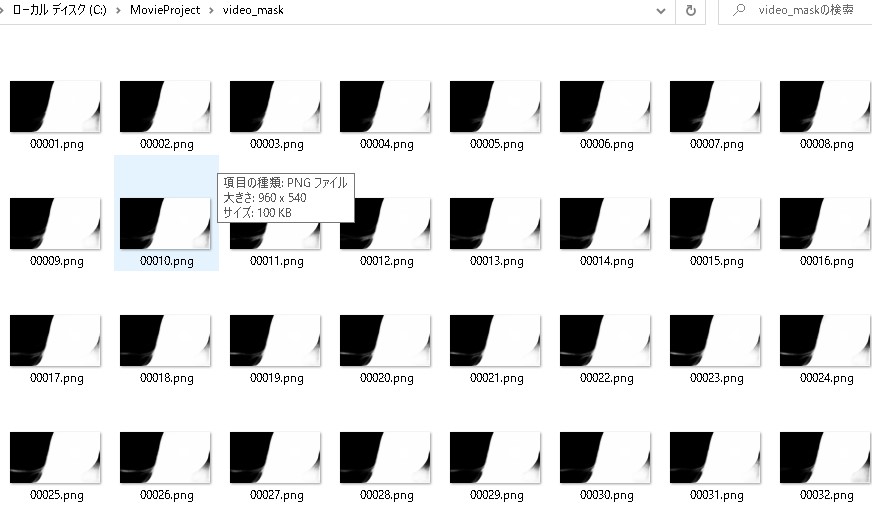

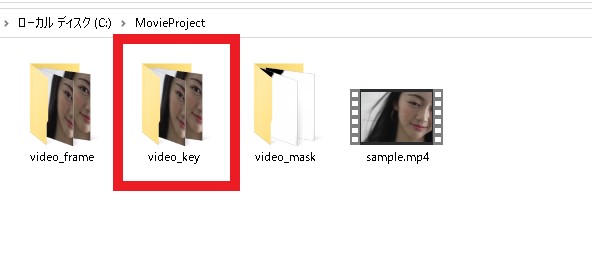

C:\MovieProject に 「 video_frame 」フォルダ と 「 video_mask 」フォルダが生成されています。

※「 video_frame 」フォルダ

※「 video_mask 」フォルダ

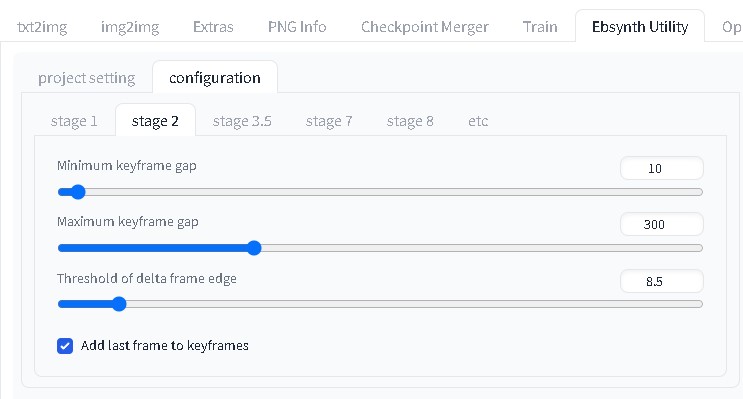

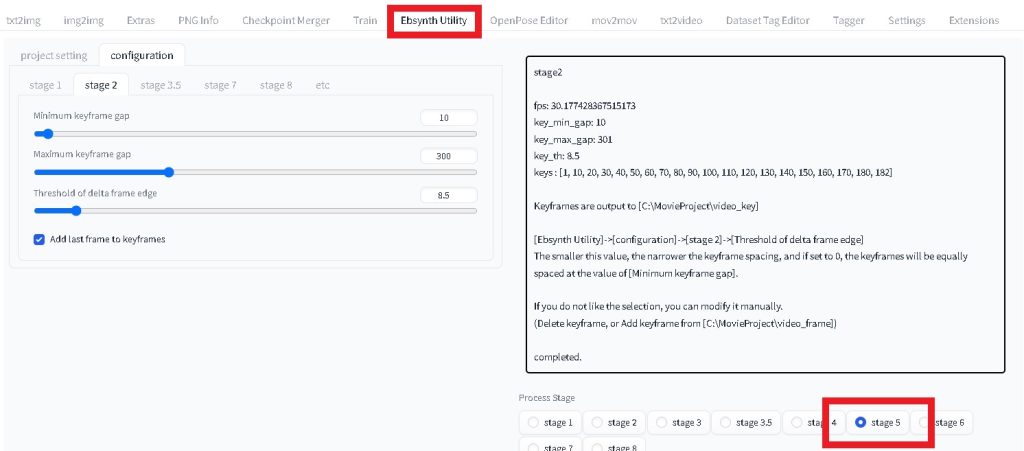

キーフレームの抽出

[ Stage2 ]タブをクリック

「 Stage2 」をチェック!

「 Generate 」をクリック!

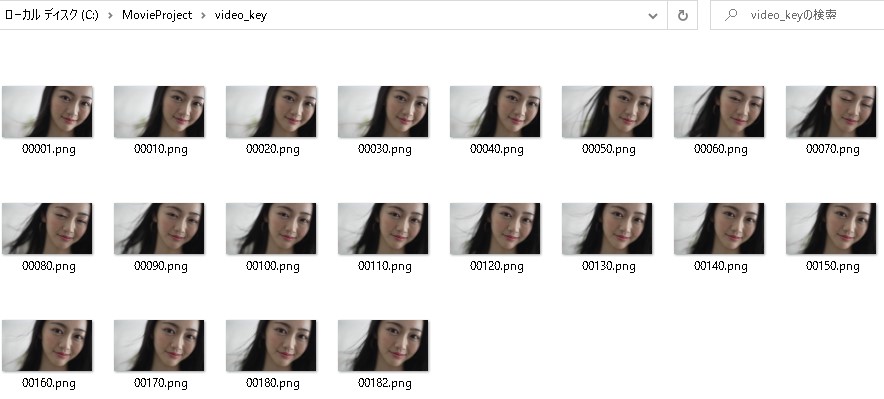

C:\MovieProject に 「 video_key 」フォルダが生成されています。

※「 video_key 」フォルダ

作成画像の調整

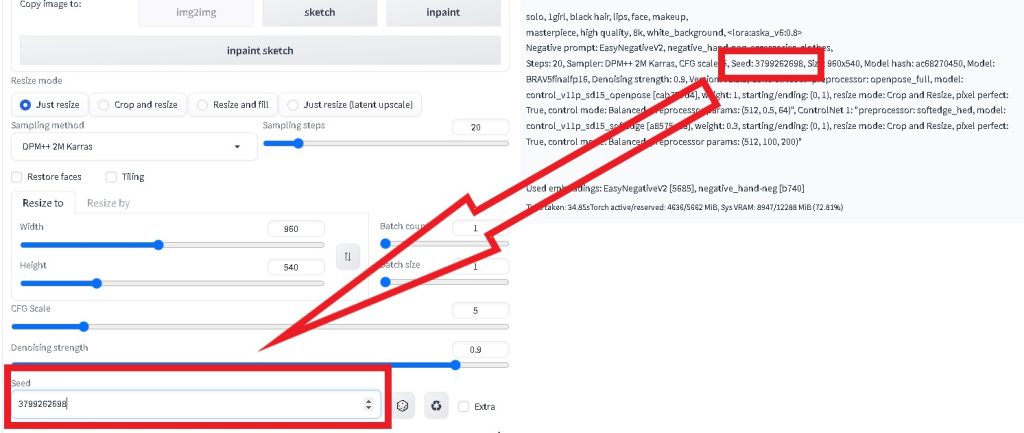

[ img2img ]タブをクリック

「 video_key 」フォルダの1枚から、最適な画像をジェネレート!

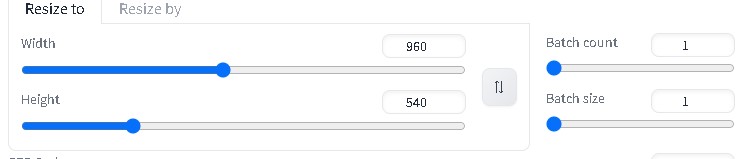

元データの幅と高さを揃える

Width: 960

Height: 540

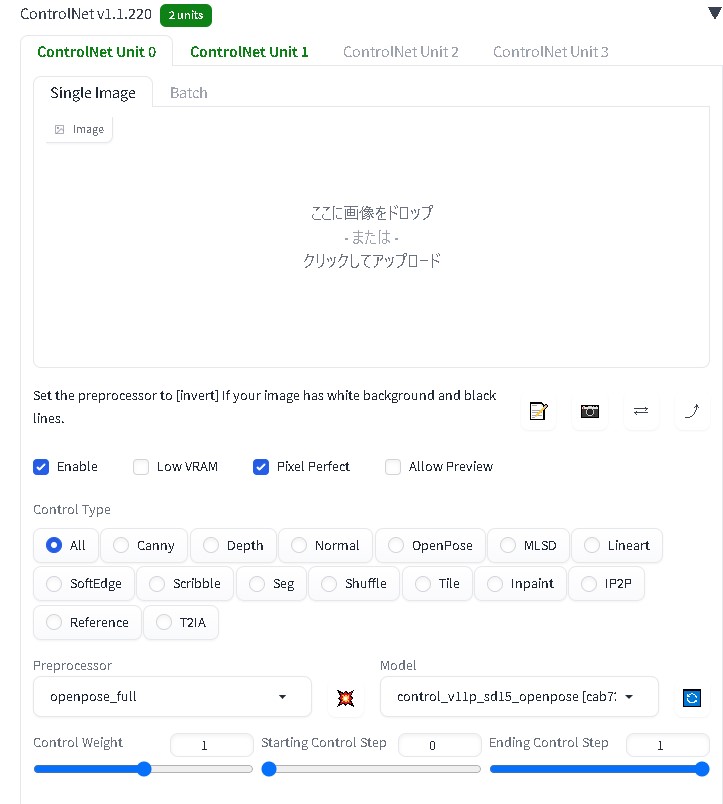

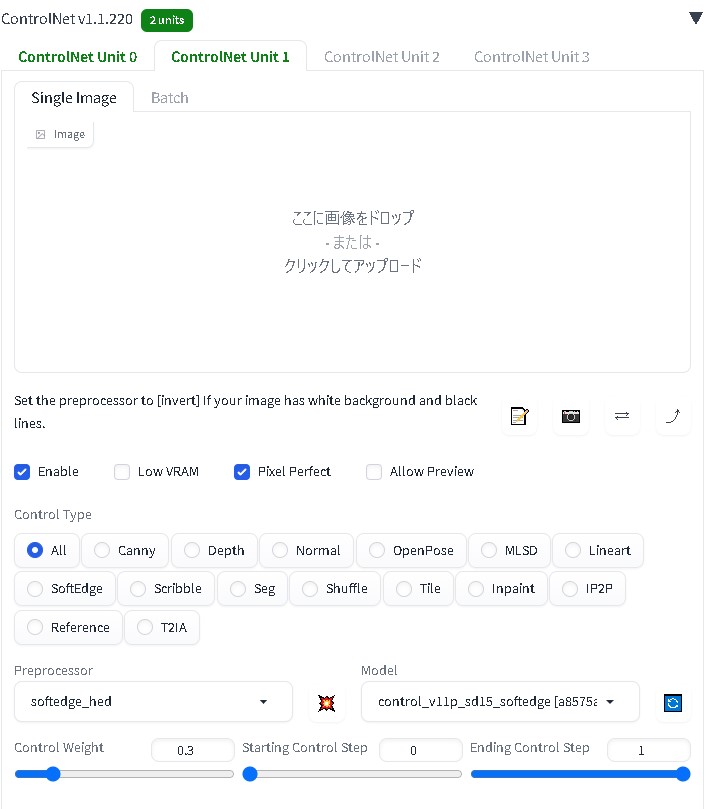

ControlNetで元データから形状などを継承する

※OpenPose

※SoftEdge

設定が決まったら、Seed値を代入する (Seed値固定)

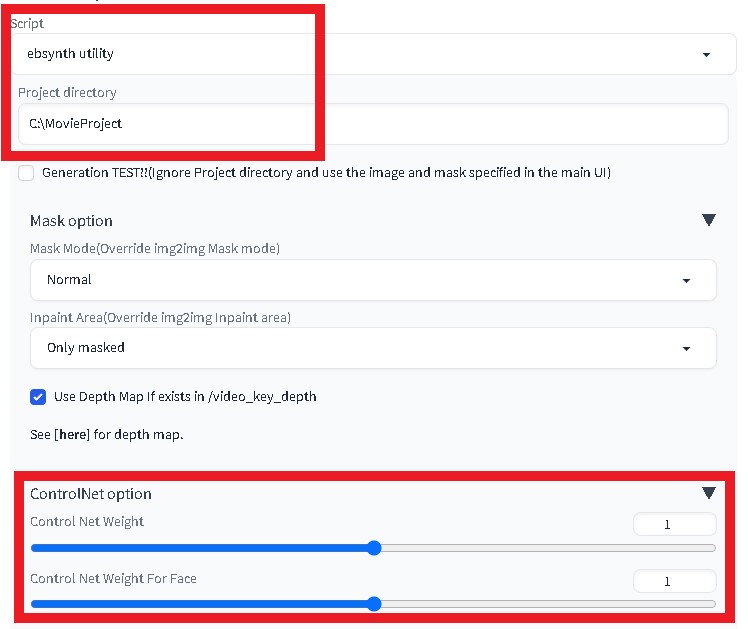

Script: ebsynth utility

Project directory: C:\MovieProject

ControlNet option

Control Net Weight: 1

Control Net Weight For Face: 1

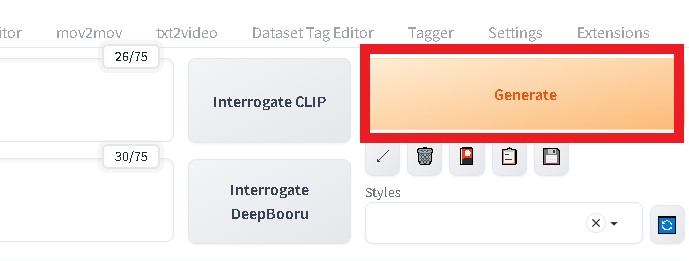

「 Generate 」をクリック!

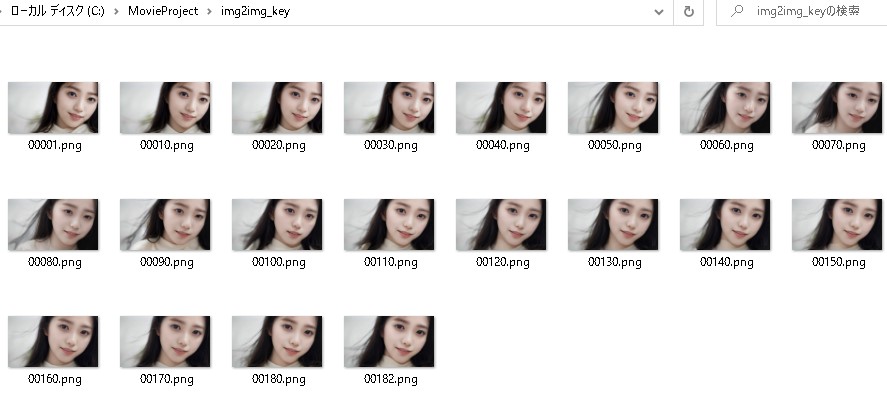

C:\MovieProject に 「 img2img_key 」フォルダが生成されています。

※「 img2img_key 」フォルダ

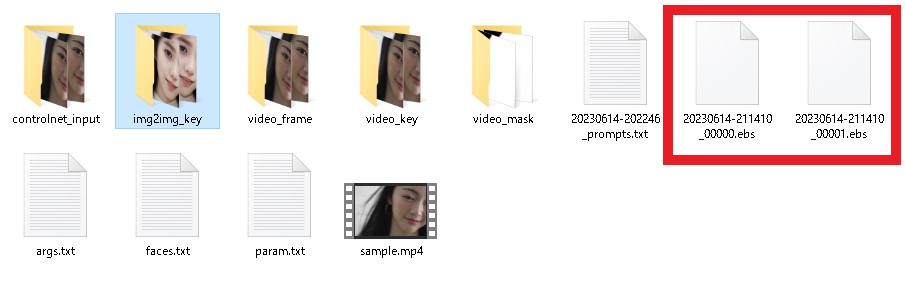

動画の制作

[ EbSynth Utility ]タブ → [ stage5 ]チェック

「 Generate 」をクリック!

C:\MovieProject に 「 *.ebs 」ファイルが生成されています。

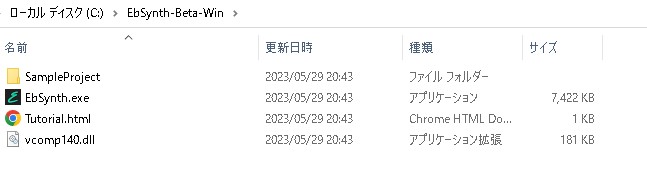

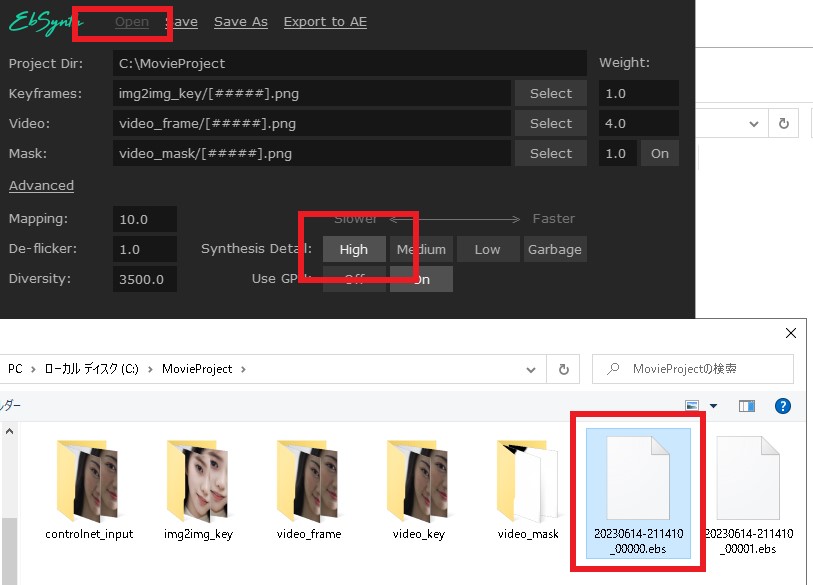

EbSynthを起動

Openで「 *_00000.ebs 」ファイルを選択

Advanced De-flicker: High

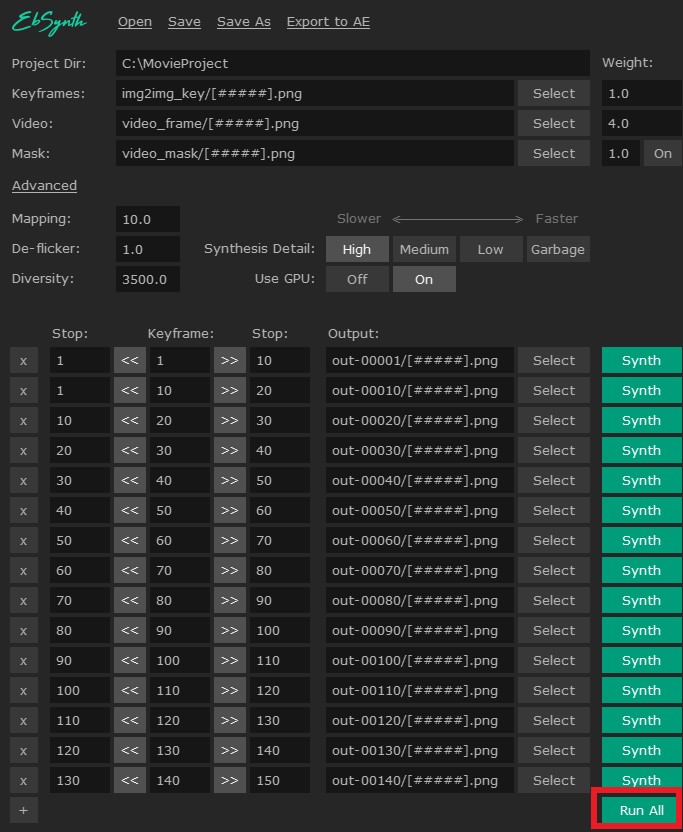

[Run All] で生成開始!

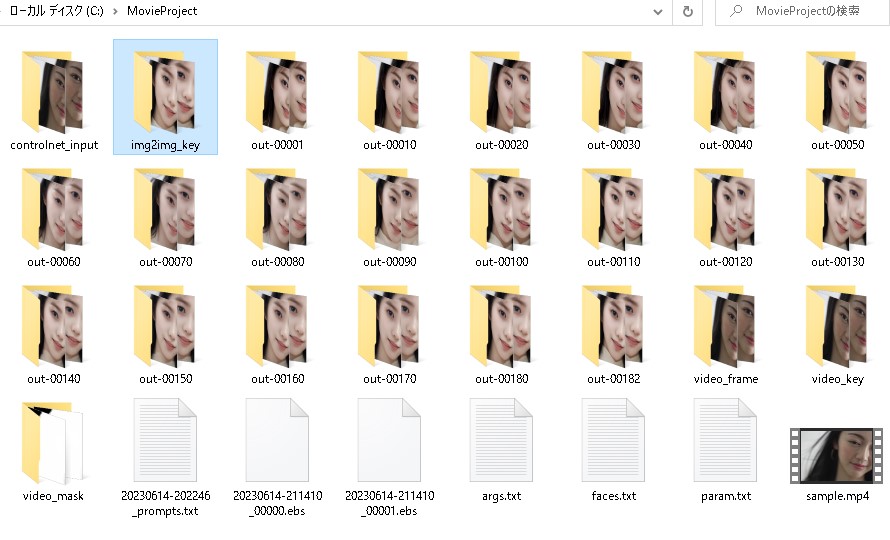

C:\MovieProject に 「out- * 」フォルダが生成されます。

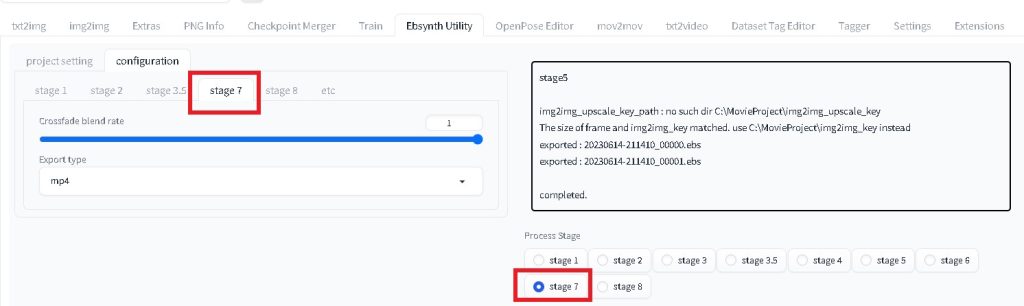

[ stage7 ]タブ選択 → [ stage7 ]チェック

「 Generate 」をクリック!

C:\MovieProject に 「 *.mp4 」ファイルが生成されます。

これで、完成です!!

完成動画